ChatGPTなど、AIがいつの間にか進化しており話題になっていますので、AIの進化について学んでいきたいと思います。AIの歴史は、下記も読んでいただければと思います。

自然言語処理に関して

AIが扱う自然言語のテキスト処理に関しては、次のように進化しています。

1.ルールベースの手法(1950年代-1990年代)

初期のAIの自然言語処理は、ルールを使用して、テキストを解析し、意味を理解するものでした。1966年にMITのジョセフ・ウェイゼンバウムによって開発されたイライザELIZAは、精神科セラピストのような役割を演じるプログラムでしたが、本物のセラピストと間違う人も現れるほどでした。

2.統計的手法 (1990年代-2010年代)

文書を「単語」を単位として、それをベクトルで表現し、大量の文書を解析し、そのパターンを利用する統計的手法が登場しました。

TF-IDF(Term Frequency-Inverse Document Frequency)は、テキストの重要度を評価するために用いられる方法です。

TF(Term Frequency):文書中にある単語の出現頻度

IDF(Inverse Document Frequency):一般的な単語かを表す指標

TFとIDFを掛け合わせた値でテキストの重要度を評価します。

3.深層学習手法 (2010年代-現在)

深層学習ではニューラルネットワークを使用して、高度なテキスト解析が可能になりました。

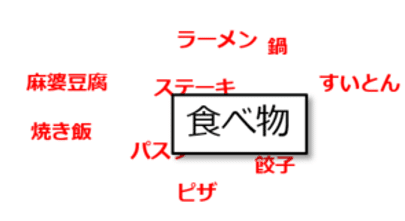

word2vecは、単語の意味的な関係性を学習することで、単語を数値化されたベクトル表現に変換します。

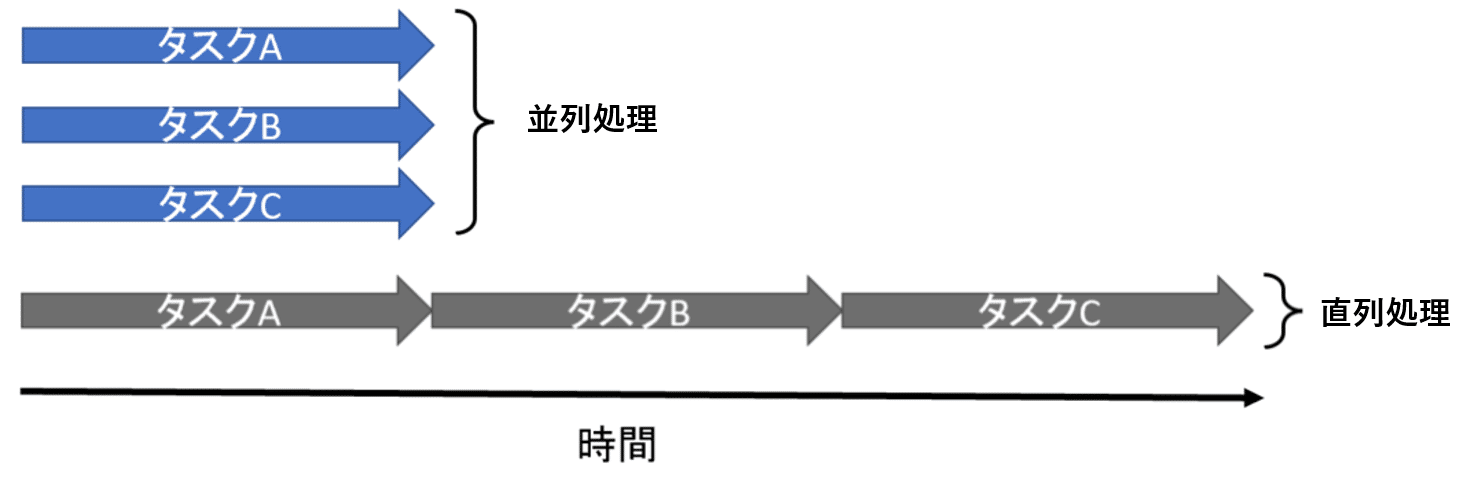

さらに2017年Googleが発表したTransformerは、並列計算が可能になり、計算が高速化しました。ここが大きなポイントです。

4.事前学習されたモデル (現在)

並列計算で高速化され、大量のテキストデータを使用してトレーニングされたニューラルネットワークのモデルになります。GPT(Generative Pre-Trained Transformer)は、大量のテキストデータを事前学習して、並行処理ができるモデルで、ChatGPTを見てもわかる通り、ほぼ自然言語であるといえます。

自然言語AIの進化

自然言語AIの進化は簡単に言うと、

①応答内容が決まっている(ルールベース)

②単語を分析して、出現頻度を分析(統計学的手法)

③ニューラルネットワークで適切な単語をつなぐ(word2vec)

④並行処理できるニューラルネットワーク(Transformer)

⑤大量に事前学習した並行処理できるニューラルネットワーク(GPT)

というように進化しています。ChatGPTが突然出てきたわけではなく、進化していることがわかると思います。

人間の脳を超える

並列処理ができるようになった段階で、処理の性能の競争が起こっているのですが、言語モデルの性能を表す指標に「パラメータ数」というものがあります。

現在、GPT-3の持つパラメータ数は175B(1750億個)で、

次に出るGPT-4は、1T(100兆個)のパラメータを持つといわれています。

100兆個は、脳のシナプス数とだいたい同じ数になります。

ChatGPT(GPT-3)の段階で自然にチャットできますので、AIが人間の脳を超える日は近いです。テキストによる自然言語処理は、AIと話したほうが早くて正確な時代になりますので、積極的にAIを活用していきましょう!!

あとがき

「AIによる自然言語の歴史」について記載しました。

自然言語処理の歴史は、最初は「ルールベース」で、質問に答える自然言語処理から始まって、ある程度レベルのものができ、ブームが起きます。

そこから、ルールを増やしていくのではなく、「単語」レベルで分解し、統計的に出現頻度が多いものを処理したほうが良い結果になる。

そこから「ディープラーニング」が登場し、最適な単語が選ばれるようになる。

加えて「事前学習をする」ことで、自然言語処理ができるAIが完成しているというところがすごいところだと思います。

ChatGPTは、事前学習した大量のデータから、質問された内容に対して、次に来る単語を予測して返しているだけです。

なのに、ほぼ完璧に会話できている気がするのは本当にすごい技術だと感じました。

そして、確実に進化していますので、今回のAIブームは本物ではないかと感じます。

AIを使いこなしていきましょう!!

コメント